Gelembung AI telah memikat para investor, mendorong S&P 500 ke ketinggian baru, sebagian besar berkat kartu grafis mutakhir Nvidia. GPU yang kuat ini adalah tulang punggung AI, yang melakukan operasi tensor penting yang mendukung pelatihan model AI. Keyakinan yang berlaku sederhana: AI adalah masa depan, dan berinvestasi di perusahaan yang memasok komponen vitalnya, seperti Nvidia, menjamin keuntungan. Sementara lonjakan AI ini luar biasa, ia menghadapi keterbatasan perangkat keras yang signifikan yang tidak dapat diatasi oleh Nvidia sendiri. Komputer klasik berjuang dengan menangani korelasi kompleks, tugas penting untuk AI. Tantangan ini menyerukan solusi yang mengganggu, dan komputasi kuantum menawarkan lompatan transformatif dengan mengelola korelasi kompleks ini secara efisien, sesuatu yang tidak dapat dilakukan oleh sistem klasik. Jadi, sementara kebangkitan Nvidia penting, masa depan AI bergantung pada potensi komputasi kuantum untuk memecahkan hambatan teknologi saat ini.

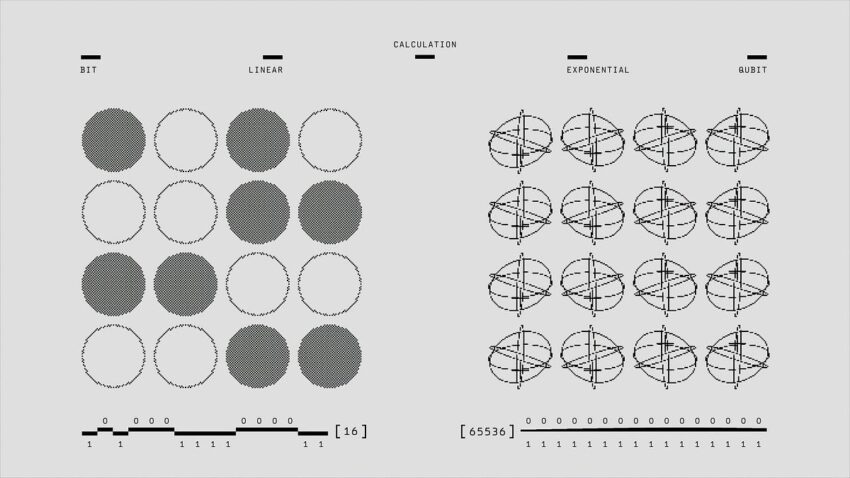

Untuk lebih memahami hal ini, mari kita gunakan sebuah analogi. Bayangkan Anda ditugaskan untuk menemukan orang yang paling berpengaruh dalam jaringan sosial yang luas. Sebuah superkomputer klasik akan melakukan hal ini dengan menugaskan prosesor individual Anda untuk menganalisis bagian-bagian jaringan yang independen. Setiap prosesor memeriksa sebagian kecil koneksi dan mengidentifikasi orang-orang yang berpengaruh dalam bagian tersebut. Kemudian, mereka menggabungkan temuan mereka untuk mendapatkan hasil keseluruhan. Metode ini dikenal sebagai pemrosesan paralel dan bekerja dengan mendistribusikan tugas-tugas tertentu ke beberapa prosesor (inti). Metode ini bergantung pada peningkatan jumlah perangkat keras yang lebih cepat dan lebih canggih (seperti chip Nvidia) untuk menangani beban kerja secara efisien. Dalam skenario yang ideal, jika Anda memiliki N bagian jaringan untuk dianalisis, Anda akan memerlukan N prosesor untuk melakukannya dengan cepat.

Pendekatan ini memiliki batasan yang melekat. Kinerja chip tidak dapat terus meningkat pada tingkat eksponensial tanpa batas karena kendala fisik. Selain itu, biaya perangkat keras dan konsumsi energi per unit peningkatan pada akhirnya akan menjadi mahal. Akibatnya, perusahaan akan mengalami pengembalian yang semakin berkurang atas investasi mereka dalam chip tambahan atau yang lebih canggih, sehingga semakin tidak ekonomis untuk mengejar jalur ini untuk meningkatkan kinerja. Perusahaan-perusahaan yang mengadopsi filosofi “lebih banyak chip, model yang lebih baik” akan segera mencapai batas kinerja. Komputer klasik, terlepas dari daya komputasinya, tidak dioptimalkan untuk menangani tugas korelasi yang kompleks secara efisien karena setiap inti memproses satu tugas pada satu waktu. Mengelola ribuan titik data yang kompleks dan saling terkait menjadi semakin tidak realistis dan tidak efisien.

Intinya, tidak peduli berapa banyak prosesor yang Anda tambahkan atau seberapa canggihnya prosesor tersebut, komputasi klasik menghadapi hambatan yang tidak dapat dihindari berkat hukum fisika klasik. Keterbatasan ini menggarisbawahi kebutuhan mendesak akan perubahan revolusioner dalam cara kita menangani tugas komputasi yang kompleks. Hal ini membawa kita pada kesenjangan dengan superkomputer masa kini: keterbatasan terbesar komputasi klasik terletak pada ketidakmampuannya untuk mengelola korelasi kompleks secara efisien.

Mengapa ini menjadi masalah yang perlu dipecahkan? Penanganan korelasi yang kompleks sangat penting bagi AI karena fungsi utamanya adalah untuk memprediksi hasil di masa mendatang, baik di pasar keuangan, pola cuaca, atau pembuatan teks. Untuk membuat prediksi yang paling akurat, AI harus menangkap korelasi yang paling rumit. Misalnya, memprediksi harga minyak memerlukan pertimbangan suku bunga, tingkat cadangan minyak, permintaan, dan berbagai faktor lainnya. Idealnya, Anda akan menggunakan setiap titik data yang memungkinkan untuk membuat simulasi dunia yang terperinci, yang memastikan prediksi masa depan yang akurat. Misalnya, memprediksi harga minyak akan memerlukan perkiraan ketegangan geopolitik, yang memengaruhi penawaran dan permintaan, serta mengantisipasi pemimpin mana yang akan berkuasa dan kebijakan potensial mereka. Ini memerlukan pemahaman yang mendalam tentang sentimen populasi dan dinamika politik, hingga preferensi dan perilaku individu. Pendekatan yang komprehensif seperti itu memberikan gambaran terperinci tentang berbagai faktor yang memengaruhi harga minyak, yang memungkinkan prediksi yang lebih akurat dan andal.

Perusahaan-perusahaan besar menyadari nilai besar dari daya prediksi dan menginvestasikan miliaran dolar untuk meningkatkannya, sebagaimana dibuktikan oleh gelembung AI. Situasi ini menggarisbawahi tiga poin penting: 1) AI bertujuan untuk memprediksi masa depan seakurat mungkin, 2) komputer klasik tidak dapat menangani korelasi kompleks yang diperlukan untuk membuat prediksi yang paling akurat, dan 3) pendekatan saat ini untuk menambahkan lebih banyak chip akan menghadapi hasil yang semakin berkurang. Oleh karena itu, meskipun kebangkitan Nvidia mengesankan, hal itu tidak akan bertahan selamanya.

Jadi, bagaimana kita dapat mengatasi masalah ini? Komputer kuantum menawarkan lompatan maju yang signifikan. Tidak seperti sistem klasik, komputer kuantum dapat memproses beberapa bagian dari suatu masalah secara bersamaan menggunakan prinsip-prinsip seperti superposisi dan keterikatan. Kemampuan ini memungkinkan komputer kuantum untuk menganalisis kumpulan data besar dengan jauh lebih efisien, mengelola korelasi kompleks yang berada di luar jangkauan sistem klasik. Pentingnya kemajuan ini tidak dapat dilebih-lebihkan. Sistem baru ini akan menjadi komponen yang tak terelakkan dari alur kerja AI di masa mendatang.

Anda mungkin berpikir ini hanya sekadar janji dan komputasi kuantum belum siap. Meskipun kehebohan AI telah menarik perhatian, kita diam-diam telah memasuki era utilitas komputasi kuantum. Era ini menandai transisi ke aplikasi komputasi kuantum yang praktis dan layak secara komersial. Kita mungkin memasuki era ini sekitar tahun 2020, dan berkembang pesat.

Izinkan saya menunjukkan bagaimana AI dapat dilakukan pada komputer kuantum. Meski masih pada tingkat dasar, poin utamanya adalah bahwa hal itu mungkin. Mari kita buktikan ini dengan menunjukkan bagaimana masalah pembelajaran mesin klasik diterjemahkan menjadi masalah pembelajaran mesin kuantum.

Mari selami cara menggunakan sirkuit kuantum variasional (VQC) sebagai pengklasifikasi dalam pembelajaran mesin kuantum.

1. Pengkodean Data

Pertama, kami mengambil data klasik dan mengodekannya ke dalam status kuantum. Ini melibatkan transformasi vektor data klasik menjadi qubit menggunakan metode seperti pengodean basis, pengodean amplitudo, atau pengodean sudut. Misalnya, dalam pengodean basis, setiap bit data menjadi status qubit, seperti |0⟩ atau |1⟩. Dalam pengodean sudut, nilai data dipetakan ke sudut rotasi qubit.

2. Rangkaian Kuantum Variasional

Selanjutnya, kami merancang sirkuit kuantum variasional dengan gerbang kuantum yang memiliki parameter yang dapat disesuaikan, seperti sudut rotasi. Data yang dikodekan berjalan melalui sirkuit ini, di mana gerbang kuantum (yang merupakan transformasi kesatuan) memanipulasi qubit. Di sinilah fenomena kuantum seperti superposisi dan keterikatan berperan. Properti ini memungkinkan komputer kuantum untuk menjelajahi beberapa status secara bersamaan dan menangani korelasi kompleks secara lebih efisien daripada algoritme klasik.

3. Pemrosesan Kuantum

Setelah data diproses oleh sirkuit kuantum, kami mengukur status kuantum. Pengukuran meruntuhkan superposisi (status probabilistik) menjadi status definitif, mengubah informasi kuantum kembali menjadi data klasik, biasanya dalam bentuk string bit. Untuk klasifikasi biner, pendekatan umum adalah menggunakan fungsi paritas pada hasil pengukuran: jika jumlah angka 1 dalam string bit ganjil, klasifikasikan sebagai 1; jika genap, klasifikasikan sebagai 0.

4. Optimasi Parameter

Untuk memperbarui parameter model, kami menggunakan metode optimasi klasik seperti penurunan gradien. Ini melibatkan penyesuaian berulang pada parameter gerbang kuantum untuk meminimalkan kesalahan klasifikasi. Fungsi objektif, sering kali kesalahan klasifikasi atau fungsi kerugian terkait, dievaluasi dan gradiennya dihitung untuk memandu pembaruan parameter.

5. Siklus Pelatihan

Siklus pengodean data, pemrosesan melalui sirkuit kuantum, pengukuran, dan pengoptimalan parameter ini diulang beberapa kali. Setiap iterasi bertujuan untuk mengurangi kesalahan klasifikasi, sehingga meningkatkan akurasi model dari waktu ke waktu. Pendekatan hibrida ini memanfaatkan kekuatan komputasi kuantum dan klasik.

Kesimpulannya, meskipun kemajuan Nvidia telah mendorong pertumbuhan signifikan di sektor AI, komputer klasik menghadapi keterbatasan inheren dalam menangani korelasi yang kompleks. Masa depan AI bergantung pada upaya mengatasi hambatan ini, yang dijanjikan akan dicapai oleh komputasi kuantum. Dengan kemampuannya untuk memproses beberapa bagian masalah secara bersamaan menggunakan superposisi dan keterikatan, komputasi kuantum menawarkan lompatan maju yang transformatif.

Saat kita memasuki era utilitas komputasi kuantum, aplikasi praktis dan layak secara komersial mulai menjadi kenyataan. Teknologi ini akan memainkan peran penting dalam memajukan AI, yang menghasilkan prediksi yang lebih akurat dan andal di berbagai bidang.