Poin-poin Utama

- Model pembelajaran mendalam dapat mengingat data pelatihan kata demi kata, sehingga sulit untuk menghapus informasi sensitif tanpa memulai dari awal.

- Pembelajaran ulang mesin merupakan bidang yang berkembang yang bertujuan untuk menghilangkan data tertentu dari model yang terlatih, tetapi menantang dan mahal.

- Berbagai teknik, seperti penghapusan data secara tepat dan penghapusan data secara perkiraan, ada untuk mengurangi dampak penghapusan data dari model.

Model pembelajaran mendalam telah mendorong 'revolusi' AI dalam dua tahun terakhir, memberi kita akses ke segala hal mulai dari alat pencarian baru yang mencolok hingga generator gambar yang menggelikan. Namun, model-model ini, meskipun menakjubkan, memiliki kemampuan untuk menghafal informasi pelatihan secara efektif dan mengulanginya kata demi kata, yang merupakan masalah potensial. Tidak hanya itu, setelah dilatih, sangat sulit untuk benar-benar menghapus data dari model seperti GPT-4. Misalnya, model ML Anda secara tidak sengaja dilatih pada data yang berisi detail bank seseorang, bagaimana Anda bisa 'menghapus' pelatihan model tersebut tanpa memulai dari awal?

Untungnya, ada bidang penelitian yang sedang mencari solusinya. Pembelajaran ulang mesin adalah bidang penelitian yang sedang berkembang tetapi semakin menarik, dengan beberapa pelaku serius mulai terlibat. Jadi, apa itu pembelajaran ulang mesin, dan apakah LLM dapat benar-benar melupakan apa yang pernah diberikan kepada mereka?

Terkait

Kesepakatan ChatGPT Apple adalah cara Apple untuk menipu dalam perlombaan asisten

WWDC telah datang dan berlalu, dan salah satu pengumuman terbesarnya adalah kesepakatan ChatGPT Apple untuk memberi kekuatan super pada Siri.

Bagaimana model dilatih

Kumpulan data yang besar diperlukan untuk model LLM atau ML yang besar

Sumber: Lenovo

Seperti yang telah kita bahas sebelumnya, model pembelajaran mesin menggunakan sejumlah besar data pelatihan (kadang-kadang disebut korpus) untuk menghasilkan model berat – yaitu untuk melakukan pra-pelatihan model. Data inilah yang secara langsung menentukan apa yang dapat 'diketahui' oleh suatu model. Setelah tahap pra-pelatihan ini, suatu model Dihilangkan untuk meningkatkan hasilnya. Dalam kasus model LLM transformer seperti ChatGPT, penyempurnaan ini sering kali berbentuk RLHF (pembelajaran penguatan dengan umpan balik manusia), di mana manusia memberikan umpan balik langsung kepada model untuk meningkatkan jawabannya.

Pelatihan salah satu model ini memerlukan biaya yang sangat besar. Sebuah laporan oleh Informasi awal tahun ini menyebutkan biaya operasional harian ChatGPT sekitar $700.000 dolar. Pelatihan model ini membutuhkan daya komputasi GPU yang besar, yang mahal dan semakin langka.

Memasuki pembelajaran mesin

Bagaimana jika kita ingin menghapus sedikit data pelatihan?

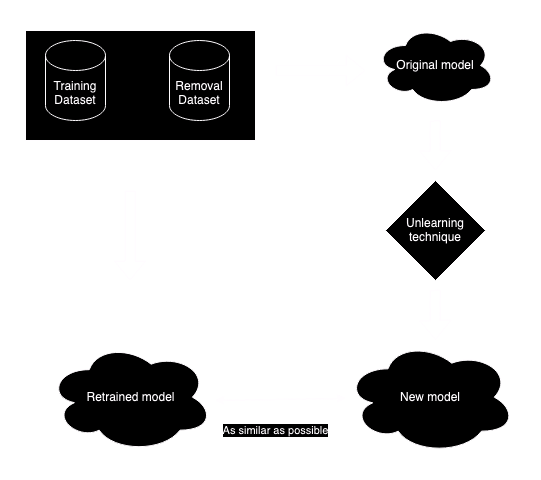

Machine unlearning benar-benar seperti namanya. Bisakah kita menghapus sedikit data tertentu dari model yang sudah dilatih? Machine unlearning adalah pengembangan (Google baru-baru ini mengumumkan yang pertama tantangan melupakan pembelajaran mesin) menjadi bidang penelitian yang sangat penting untuk pembelajaran mendalam. Meskipun kedengarannya sederhana, itu jauh dari mudah. Jawaban yang mudah adalah melatih ulang model, dikurangi kumpulan data yang akan dihapus. Namun, seperti yang telah kami sebutkan, ini sering kali sangat mahal dan/atau memakan waktu. Untuk model pembelajaran terfederasi yang berpusat pada privasi, ada masalah kedua – kumpulan data asli mungkin tidak lagi tersedia. Tujuan sebenarnya dari pembelajaran ulang mesin adalah untuk menghasilkan model sedekat mungkin dengan model yang dilatih ulang sepenuhnya, dikurangi data yang bermasalah, untuk sedekat mungkin dengan pelatihan ulang model sepenuhnya tanpa benar-benar melakukannya.

Direproduksi dari (1)

Jika kita tidak dapat melatih ulang model, dapatkah kita menghapus bobot tertentu untuk menghalangi pengetahuan model tentang kumpulan data target? Jawaban yang mungkin di sini juga, tidak. Pertama, memastikan bahwa kumpulan data target telah dihapus sepenuhnya dengan melakukan intervensi langsung pada model hampir mustahil; kemungkinan besar fragmen data target akan tetap ada. Kedua, dampak pada kinerja keseluruhan model juga sulit untuk diukur, dan mungkin berdampak buruk tidak hanya pada kinerja keseluruhan tetapi juga pada area spesifik lain dari pengetahuan model. Karena alasan itu (dan alasan lainnya), secara umum dianggap tidak praktis untuk langsung menghapus elemen dari model.

Teknik menghilangkan parameter model tertentu ini terkadang dikenal sebagai

pergeseran model

.

Teknik untuk melupakan pembelajaran mesin sudah ada

Ada beberapa algoritma yang ada untuk melupakan pembelajaran mesin, yang secara garis besar dapat dipecah menjadi beberapa jenis. Pembelajaran yang tepat berupaya membuat keluaran dari model yang dilatih ulang dan model asli tidak dapat dibedakan, selain dari kumpulan data khusus yang tidak dipelajari. Ini adalah bentuk paling ekstrem dari tidak dipelajari, dan memberikan jaminan terkuat bahwa tidak ada data yang tidak diinginkan yang dapat diekstraksi. Pembelajaran yang kuat lebih mudah diimplementasikan daripada pembelajaran ulang yang tepat, tetapi hanya mengharuskan kedua model tersebut hampir tidak dapat dibedakan. Namun, hal ini tidak menjamin bahwa beberapa informasi tidak akan tetap ada dari kumpulan data yang diekstraksi. Terakhir, lemah tidak belajar adalah yang paling mudah diimplementasikan, tetapi tidak menjamin bahwa data pelatihan yang dihapus tidak lagi disimpan secara internal. Secara keseluruhan, unlearning yang kuat dan lemah terkadang dikenal sebagai unlearning perkiraan.

Teknik melupakan pembelajaran mesin

Sekarang ini menjadi sedikit teknis, tetapi kita akan membahas beberapa teknik umum untuk melupakan pembelajaran mesin. Metode melupakan pembelajaran yang tepat adalah yang paling sulit diterapkan pada LLM besar, dan sering kali bekerja paling baik pada model yang sederhana dan terstruktur. Ini mungkin termasuk teknik seperti membalikkan tetangga terdekatyang mencoba mengkompensasi penghapusan titik data dengan menyesuaikan tetangganya. K-tetangga terdekat adalah ide yang serupa, tetapi menghapus titik data berdasarkan kedekatannya dengan bit data target alih-alih menyesuaikannya. Ide umum lainnya adalah membagi kumpulan data menjadi beberapa subset, dan melatih serangkaian model parsial yang nantinya dapat digabungkan (sering dikenal sebagai sharding). Jika bit data tertentu perlu dihapus, kumpulan data yang memuatnya dapat dilatih ulang lalu digabungkan dengan kumpulan data yang ada.

Metode pembelajaran ulang perkiraan lebih umum. Ini mungkin termasuk pembelajaran bertahapyang dibangun di atas model yang ada untuk menyesuaikan output dan 'melupakan' data. Ini paling efektif untuk pembaruan dan penghapusan kecil, dan merupakan bagian dari penyempurnaan model yang sedang berlangsung. Metode berbasis gradien mirip dengan RNN di atas, karena metode ini mencoba mengompensasi titik data yang dihapus dengan membalikkan pembaruan gradien yang diterapkan selama pelatihan. Metode ini bisa akurat, tetapi sering kali memerlukan komputasi yang mahal dan kesulitan dengan model yang lebih besar.

Ada teknik lain yang tidak akan kita bahas di sini, tetapi secara umum teknik-teknik tersebut menawarkan beberapa keseimbangan antara biaya komputasi, akurasi, dan seberapa baik teknik tersebut dapat diskalakan ke model yang besar.

Pembelajaran mesin yang tidak lagi dipelajari merupakan topik yang semakin penting

‘Kesalahan’ dalam data pelatihan bisa menjadi lebih merugikan

Sumber: Unsplash

Pembelajaran ulang mesin kemungkinan akan menjadi topik hangat selama beberapa tahun ke depan, terutama karena LLM telah menjadi semakin kompleks dan mahal untuk dilatih. Ada peningkatan risiko bahwa regulator atau hakim mungkin meminta pembuat model besar untuk menghapus bit data tertentu dari AI mereka, baik karena lisensi atau pelanggaran hak cipta. Legislasi GDPR atau 'hak untuk dilupakan' sudah ada di beberapa negara di seluruh dunia. Perusahaan seperti OpenAI telah terperangkap dalam kontroversi signifikan menggunakan data pelatihan tanpa lisensi dari New York Times, dan peningkatan penggunaan konten buatan pengguna berlisensi berpotensi menyebabkan masalah berkelanjutan seputar kepemilikan konten (seperti yang telah ditemukan Stack Overflow). OpenAI juga telah terlibat dalam kontroversi yang berasal dari penggunaan karya seni berhak cipta daring (seperti yang dilakukan banyak pihak lain) dalam melatih model mereka, yang memunculkan perdebatan baru tentang modifikasi baru.

Unlearning adalah bidang yang sedang berkembang

Seiring dengan melambatnya lanskap AI dari laju kemajuan yang luar biasa selama tahun 2023, regulator mulai mengejar masalah seputar pelatihan AI. Perlombaan untuk mendapatkan data pelatihan dengan cepat mengubah internet menjadi tempat yang semakin sekuler dan terbagi, seperti yang ditunjukkan oleh Google baru-baru ini kesepakatan eksklusivitas dengan Reddit. Apakah pengadilan dan regulator akan mengambil tindakan tegas untuk memaksa pelatihan ulang dan penghapusan data dari model melewati level permukaan, kita lihat saja nanti. Namun, terlepas dari implikasi privasi, penghapusan pembelajaran mesin berpotensi menjadi teknik yang rumit namun berguna, tidak hanya untuk melupakan data dari model, tetapi juga untuk mengoreksi kesalahan dalam data pelatihan di kemudian hari.